python爬取淘宝商品详情页数据

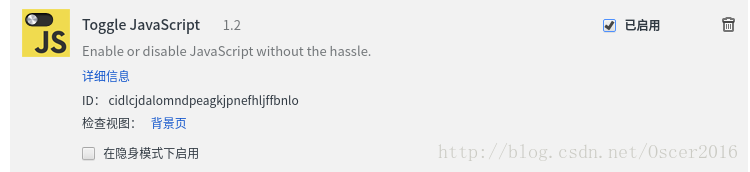

在讲爬取淘宝详情页数据之前,先来介绍一款 Chrome 插件:Toggle JavaScript (它可以选择让网页是否显示 js 动态加载的内容),如下图所示:

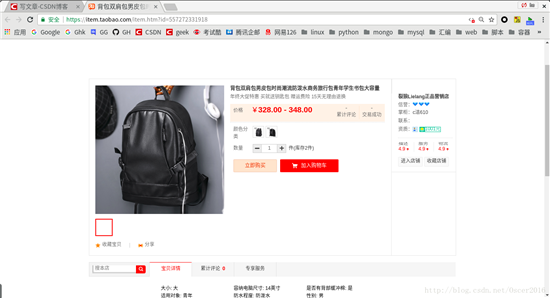

当这个插件处于关闭状态时,待爬取的页面显示的数据如下:

当这个插件处于打开状态时,待爬取的页面显示的数据如下:

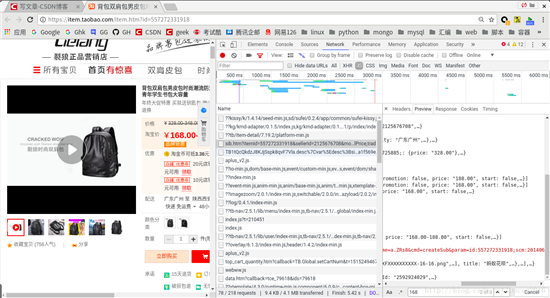

可以看到,页面上很多数据都不显示了,比如商品价格变成了划线价格,而且累计评论也变成了0,说明这些数据都是动态加载的,以下演示真实价格的找法(评论内容找法类似),首先检查页面元素,然后点击Network选项卡,刷新页面,可以看到很多动态加载的数据,在里面找到包含商品价格的链接(可以使用Ctrl+f查找),如下图所示:

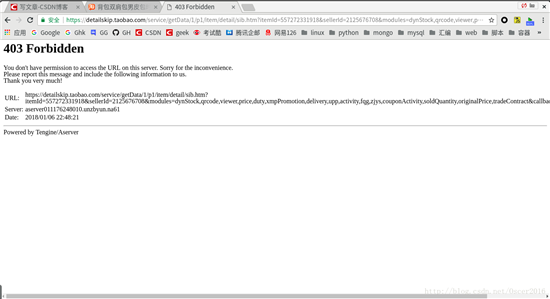

将此链接在新的标签页打开,如下图所示,可以看到,被禁止访问了,所以爬取的时候要在headers中加上Referer字段告诉服务器你是从哪个页面链接过来的,Referer字段可以在这里查看:

评论数据的链接可以直接访问(和价格信息找法类似),这里我知己去访问它,如下图所示:

可以看到评论信息总共有7页,而且都是json格式的数据,所以可以用json反序列化去抽取数据,当然也可以用正则表达式,下面我将演示用正则去抽取数据,因为评论数据过多,这里只抓取第一页,如果需要所有评论数据,可以循环构造url,只需要修改currentPage参数的值就行。程序源码如下:

# filename:spider_taobao.py

#!/usr/bin/env python

# -*- coding=utf-8 -*-

import re

import urllib2

def spider_taobao(url):

headers = {

'Accept':'application/json, text/plain, */*',

'Accept-Language':'zh-CN,zh;q=0.3',

'Referer':'https://item.taobao.com/item.htm',

'User-Agent':'Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.36',

'Connection':'keep-alive',

}

goods_id = re.findall('id=(\d+)', url)[0]

try:

req = urllib2.Request(url=url, headers=headers)

res = urllib2.urlopen(req).read().decode('gbk', 'ignore')

except Exception as e:

print '无法打开网页:', e.reason

try:

title = re.findall('<h3 class="tb-main-title" data-title="(.*?)"', res)

title = title[0] if title else None

line_price = re.findall('<em class="tb-rmb-num">(.*?)</em>', res)[0]

# 30-42行为抓取淘宝商品真实价格,该数据是动态加载的

purl = "https://detailskip.taobao.com/service/getData/1/p1/item/detail/sib.htm?itemId={}&modules=price,xmpPromotion".format(goods_id)

price_req = urllib2.Request(url=purl, headers=headers)

price_res = urllib2.urlopen(price_req).read()

data = list(set(re.findall('"price":"(.*?)"', price_res)))

# data列表中的价格可能是定值与区间的组合,也可能只是定值,而且不一定有序

real_price = ""

for t in data:

if '-' in t:

real_price = t

break

if not real_price:

real_price = sorted(map(float, data))[0]

# 45-53行为抓取评论数据,该数据也是动态加载的

comment_url = "https://rate.tmall.com/list_detail_rate.htm?itemId={}&sellerId=880734502¤tPage=1".format(goods_id)

comment_data = urllib2.urlopen(comment_url).read().decode("GBK", "ignore")

temp_data = re.findall('("commentTime":.*?),"days"', comment_data)

temp_data = temp_data if temp_data else re.findall('("rateContent":.*?),"reply"', comment_data)

comment = ""

for data in temp_data:

comment += data.encode('utf-8')

comment = comment if comment else "暂无评论"

except Exception as e:

print '数据抽取失败!!!'

print '商品名:', title

print '划线价格:', line_price

print '真实价格:', real_price

print '商品链接:', url

print '部分评论内容:', comment

if __name__ == '__main__':

#url = 'https://item.taobao.com/item.htm?spm=a230r.1.14.30.43306a3fOeuZ0B&id=553787375606&ns=1&abbucket=10#detail'

url = raw_input("请输入商品链接: ")

spider_taobao(url)

运行结果如下:

更多内容请参考专题《python爬取功能汇总》进行学习。

以上就是本文的全部内容,希望对大家的学习有所帮助,也希望大家多多支持【听图阁-专注于Python设计】。