python实现从web抓取文档的方法

本文实例讲述了Python实现从Web的一个URL中抓取文档的方法,分享给大家供大家参考。具体方法分析如下:

实例代码如下:

import urllib

doc = urllib.urlopen("http://www.python.org").read()

print doc#直接打印出网页

def reporthook(*a):

print a

#将http://www.renren.com网页保存到renre.html中,

#每读取一个块调用一字reporthook函数

urllib.urlretrieve("http://www.renren.com",'renren.html',reporthook)

#将http://www.renren.com网页保存到renre.html中

urllib.urlretrieve("http://www.renren.com",'renren.html')

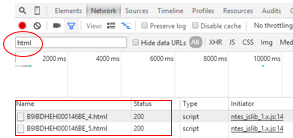

程序运行结果如下:

<!DOCTYPE html PUBLIC "-//W3C//DTD XHTML 1.0 Transitional//EN" "http://www.w3.org/TR/xhtml1/DTD/xhtml1-transitional.dtd"> ..........................网页内容 </body> </html> (0, 8192, -1) (1, 8192, -1) (2, 8192, -1)

其中urllib.urlopen返回一个类文件对象。

希望本文所述对大家的Python程序设计有所帮助。