用Python实现大文本文件切割的方法

在实际工作中,有些场景下,因为产品既有功能限制,不支持特大文件的直接处理,需要把大文件进行切割处理。

当然可以通过UltraEdit编辑工具,或者从网上下载一些文件切割器之类的。但这些要么手工操作太麻烦,要么不能满足自定义需求。

而且,对程序员来说,DIY一个轮子还是有必要的。

Python作为快速开发工具,其代码表达力强,开发效率高,因此用Python快速写一个,还是可行的。

需求描述:

输入:给定一个带列头的csv文件,或者txt文件,或者其他文本文件。

输出:指定单文件内部行数的一系列可区分小文件。

开发环境:Python 3.6

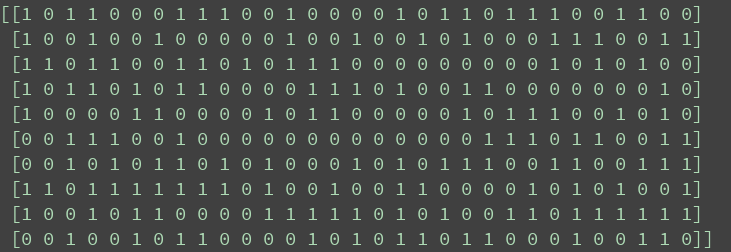

代码如下:

# -*- coding: cp936 -*-

import os

import time

def mkSubFile(lines,head,srcName,sub):

[des_filename, extname] = os.path.splitext(srcName)

filename = des_filename + '_' + str(sub) + extname

print( 'make file: %s' %filename)

fout = open(filename,'w')

try:

fout.writelines([head])

fout.writelines(lines)

return sub + 1

finally:

fout.close()

def splitByLineCount(filename,count):

fin = open(filename,'r')

try:

head = fin.readline()

buf = []

sub = 1

for line in fin:

buf.append(line)

if len(buf) == count:

sub = mkSubFile(buf,head,filename,sub)

buf = []

if len(buf) != 0:

sub = mkSubFile(buf,head,filename,sub)

finally:

fin.close()

if __name__ == '__main__':

begin = time.time()

splitByLineCount('盂县.csv',600000)

end = time.time()

print('time is %d seconds ' % (end - begin))

测试结果:

1.4GB的csv文件,13列数据,切分成23个小文件,耗时55秒。

以上这篇用Python实现大文本文件切割的方法就是小编分享给大家的全部内容了,希望能给大家一个参考,也希望大家多多支持【听图阁-专注于Python设计】。