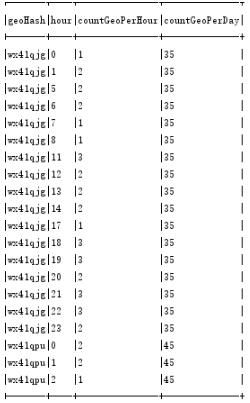

spark dataframe 将一列展开,把该列所有值都变成新列的方法

The original dataframe

需求:hour代表一天的24小时,现在要将hour列展开,每一个小时都作为一个列

实现:

val pivots = beijingGeoHourPopAfterDrop.groupBy("geoHash").pivot("hour").sum("countGeoPerHour").na.fill(0)

并且统计了对应的countGeoPerHour的和,如果有些行没有这个新列对应的数据,将用null填充

The new dataframe

以上这篇spark dataframe 将一列展开,把该列所有值都变成新列的方法就是小编分享给大家的全部内容了,希望能给大家一个参考,也希望大家多多支持【听图阁-专注于Python设计】。