我用Python抓取了7000 多本电子书案例详解

安装

安装很简单,只要执行:

pip install requests-html

就可以了。

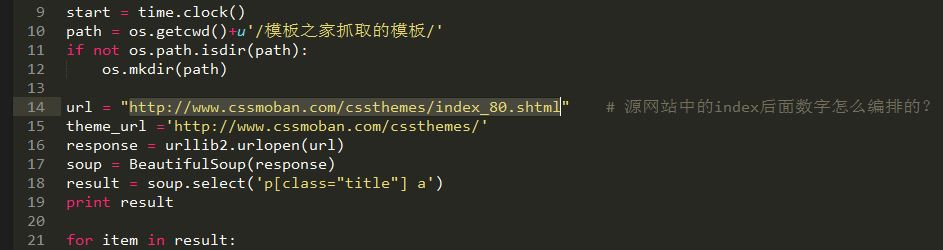

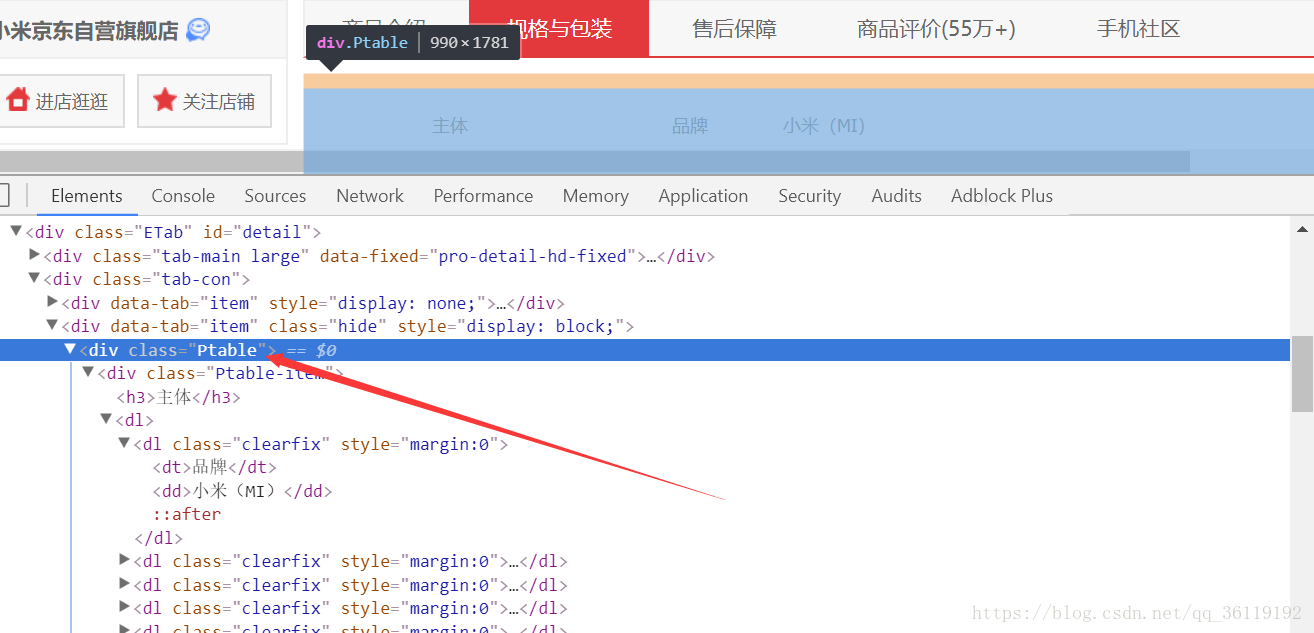

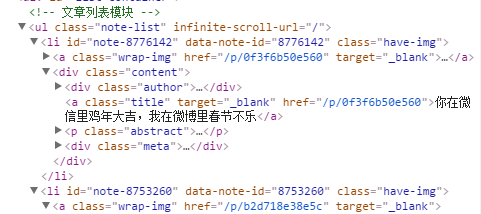

分析页面结构

通过浏览器审查元素可以发现这个电子书网站是用 WordPress 搭建的,首页列表元素很简单,很规整

所以我们可以查找 .entry-title > a 获取所有图书详情页的链接,接着我们进入详情页,来寻找下载链接,由下图

可以发现 .download-links > a 里的链接就是该书的下载链接,回到列表页可以发现该站一共 700 多页,由此我们便可以循环列表获取所有的下载链接。

Requests-html 快速指南

发送一个 GET 请求:

from requests_html import HTMLSession

session = HTMLSession()

r = session.get('https://python.org/')

Requests-html 的方便之处就是它解析 html 方式就像使用 jQuery 一样简单,比如:

# 获取页面的所有链接可以这样写:

r.html.links

# 会返回 {'//docs.python.org/3/tutorial/', '/about/apps/'}

# 获取页面的所有的绝对链接:

r.html.absolute_links

# 会返回 {'https://github.com/python/pythondotorg/issues', 'https://docs.python.org/3/tutorial/'}

# 通过 CSS 选择器选择元素:

about = r.find('.about', first=True)

# 参数 first 表示只获取找到的第一元素

about.text # 获取 .about 下的所有文本

about.attrs # 获取 .about 下所有属性像 id, src, href 等等

about.html # 获取 .about 的 HTML

about.find('a') # 获取 .about 下的所有 a 标签

构建代码

from requests_html import HTMLSession

import requests

import time

import json

import random

import sys

'''

想要学习Python?Python学习交流群:984632579满足你的需求,资料都已经上传群文件,可以自行下载!

'''

session = HTMLSession()

list_url = 'http://www.allitebooks.com/page/'

USER_AGENTS = [

"Mozilla/5.0 (Macintosh; Intel Mac OS X 10_7_3) AppleWebKit/535.20 (KHTML, like Gecko) Chrome/19.0.1036.7 Safari/535.20",

"Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.1 (KHTML, like Gecko) Chrome/21.0.1180.71 Safari/537.1 LBBROWSER",

"Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/535.11 (KHTML, like Gecko) Chrome/17.0.963.84 Safari/535.11 LBBROWSER",

"Mozilla/4.0 (compatible; MSIE 7.0; Windows NT 6.1; WOW64; Trident/5.0; SLCC2; .NET CLR 2.0.50727; .NET CLR 3.5.30729; .NET CLR 3.0.30729; Media Center PC 6.0; .NET4.0C; .NET4.0E)",

"Mozilla/4.0 (compatible; MSIE 6.0; Windows NT 5.1; SV1; QQDownload 732; .NET4.0C; .NET4.0E)",

"Mozilla/4.0 (compatible; MSIE 7.0; Windows NT 5.1; Trident/4.0; SV1; QQDownload 732; .NET4.0C; .NET4.0E; 360SE)",

"Mozilla/4.0 (compatible; MSIE 6.0; Windows NT 5.1; SV1; QQDownload 732; .NET4.0C; .NET4.0E)",

"Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.1 (KHTML, like Gecko) Chrome/21.0.1180.89 Safari/537.1",

"Mozilla/5.0 (iPad; U; CPU OS 4_2_1 like Mac OS X; zh-cn) AppleWebKit/533.17.9 (KHTML, like Gecko) Version/5.0.2 Mobile/8C148 Safari/6533.18.5",

"Mozilla/5.0 (Windows NT 6.1; Win64; x64; rv:2.0b13pre) Gecko/20110307 Firefox/4.0b13pre",

"Mozilla/5.0 (X11; Ubuntu; Linux x86_64; rv:16.0) Gecko/20100101 Firefox/16.0",

"Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.11 (KHTML, like Gecko) Chrome/23.0.1271.64 Safari/537.11",

"Mozilla/5.0 (X11; U; Linux x86_64; zh-CN; rv:1.9.2.10) Gecko/20100922 Ubuntu/10.10 (maverick) Firefox/3.6.10"

]

# 获取当前列表页所有图书链接

def get_list(url):

response = session.get(url)

all_link = response.html.find('.entry-title a') # 获取页面所有图书详情链接

for link in all_link:

getBookUrl(link.attrs['href'])

# 获取图书下载链接

def getBookUrl(url):

response = session.get(url)

l = response.html.find('.download-links a', first=True)

if l is not None: # 运行后发现有的个别页面没有下载链接,这里加个判断

link = l.attrs['href'];

download(link)

#下载图书

def download(url):

# 随机浏览器 User-Agent

headers={ "User-Agent":random.choice(USER_AGENTS) }

# 获取文件名

filename = url.split('/')[-1]

# 如果 url 里包含 .pdf

if ".pdf" in url:

file = 'book/'+filename # 文件路径写死了,运行时当前目录必须有名 book 的文件夹

with open(file, 'wb') as f:

print("正在下载 %s" % filename)

response = requests.get(url, stream=True, headers=headers)

# 获取文件大小

total_length = response.headers.get('content-length')

# 如果文件大小不存在,则直接写入返回的文本

if total_length is None:

f.write(response.content)

else:

# 下载进度条

dl = 0

total_length = int(total_length) # 文件大小

for data in response.iter_content(chunk_size=4096): # 每次响应获取 4096 字节

dl += len(data)

f.write(data)

done = int(50 * dl / total_length)

sys.stdout.write("\r[%s%s]" % ('=' * done, ' ' * (50-done)) ) # 打印进度条

sys.stdout.flush()

print(filename + '下载完成!')

if __name__ == '__main__':

#从这运行,应为知道列表总数,所以偷个懒直接开始循环

for x in range(1,756):

print('当前页面: '+ str(x))

get_list(list_url+str(x))

运行效果:

以上所述是小编给大家介绍的我用Python抓取了7000 多本电子书案例详解整合,希望对大家有所帮助,如果大家有任何疑问请给我留言,小编会及时回复大家的。在此也非常感谢大家对【听图阁-专注于Python设计】网站的支持!