pycharm编写spark程序,导入pyspark包的3中实现方法

一种方法:

File --> Default Setting --> 选中Project Interpreter中的一个python版本-->点击右边锯齿形图标(设置)-->选择more-->选择刚才选中的那个python版本-->点击最下方编辑(也就是增加到这个python版本下)-->点击➕-->选中spark安装目录下的python目录-->一路OK。

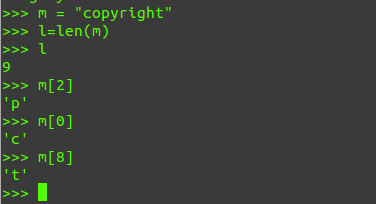

再次在python文件中写入如下

from pyspark import SparkConf

如果上一种不管用,则采用下一种。

With PySpark package (Spark 2.2.0 and later)

另一种操作方法:

1.Go to File -> Settings -> Project Interpreter

2.Click on install button and search for PySpark

第三种方法(需要先下载spark安装包):

下载spark安装包,将spark主目录中python目录中的pyspark目录拷贝到

/Library/Frameworks/Python.framework/Versions/3.5/lib/python3.5/site-packages

目录中,在pycharm中

from pyspark import SparkContext

成功,可以愉快的用python编写spark程序了。。。。